Noen er ute etter å lure deg

Du kan ikke tro det selv om du har sett det

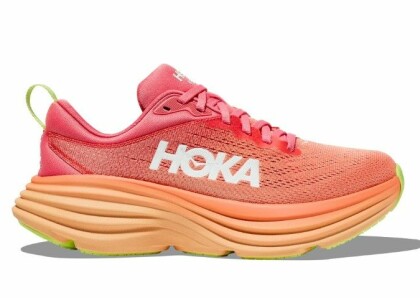

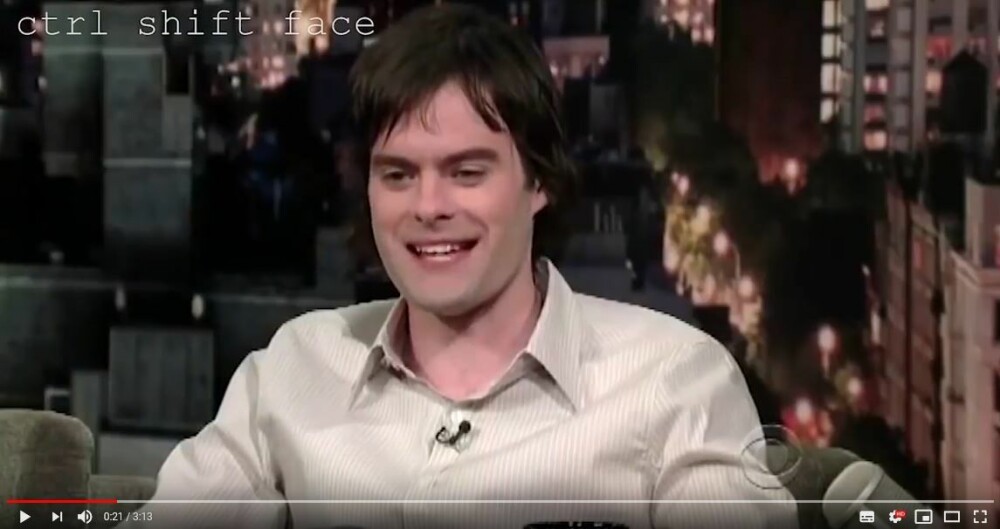

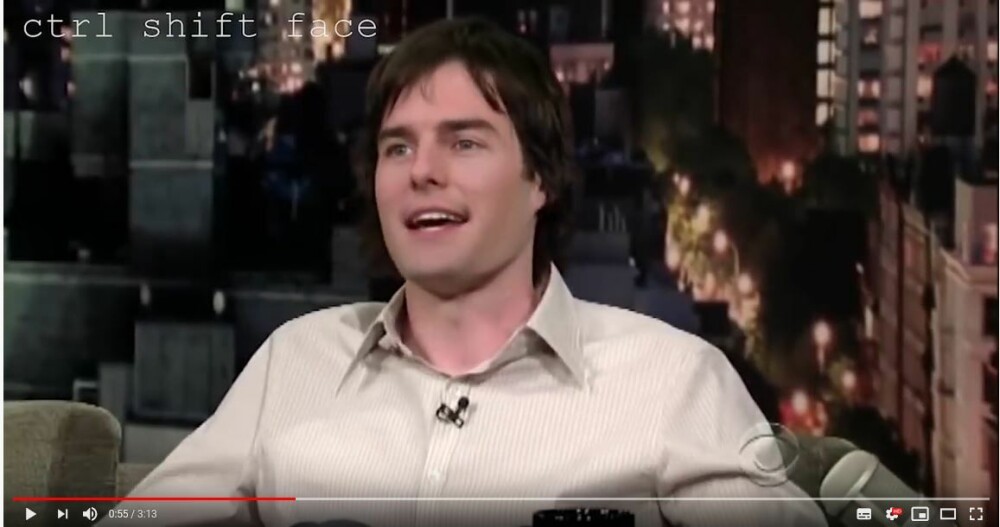

Ville et slikt bilde få deg til å tro at Erna og Jonas har sagt det som står i snakkeboblene? Ikke? Men hva om du hadde sett og hørt dem si det samme på en video på sosiale medier? Se opp for fenomenet «deepfake», teknologien som sprer skrekk. Se også eksempler på teknologien i filmklippene vi har lagt ved.

Se for deg at du åpner Facebook, og finner et videoklipp av Jonas Gahr Støre eller Erna Solberg snakke begeistret om pedofili. Ville du trodd på det du så? Hva om de i stedet snakket varmt for flere og dyrere bomstasjoner langs veiene eller ekstra skatt på strømforbruket til barnefamilier? Ville du latt raseriet bruse umiddelbart?

Du har jo sett det på filmklippet, leppebevegelse stemmer med ordene. Da må det jo være sant?

Ikke nå lenger. Og det bekymrer stadig flere fra etterretningstopper i USA til norske lokalavisredaksjoner. For tiden der man kunne stole på hva øynene så er forbi og like avleggs som den påstanden om at «det må jo være sant, for det sto i avisa».

Du kan like godt lære begrepet «deepfakes» med en gang.

Det kommer til å kreve en omstilling i hodene våre: Lenge tok vi for gitt at det som ble formidlet av levende bilder via fjernsynsapparatet, var sannheten. TVs evne til å formidle sannheten var uovertruffen.

Vær på vakt!

Heretter må vi være langt mer på vakt når dramatiske sekvenser blir avspilt, og når oppsiktsvekkende utsagn kommer fra både kjente og ukjente personers munn. Det gjelder både på tradisjonelle etermedier og sosiale medier på nett.

En video er ikke lengre noe man uforbeholdent bør tro på, om vi skal tro dystre fremtidsspådommer. Og enda verre: Vi kan ikke uten videre stole på

normalt troverdige kilder heller, dersom de baserer sine utsagn, vurderinger eller nyhetsmeldinger på videoer de har blitt presentert.

I takt med at datamaskiner blir kraftigere og teknologien for bildemanipulering bedre, er det i stadig større grad grunn til å tvile på det man ser.

Hvem kan vi tro på?

Såkalte «Deepfakes» er gjerne manipulerte videoer og bilder, skapt ved hjelp av kunstig dataintelligens basert på maskinlæring, og et kraftig spill-grafikkort.

Resultatet kan være at et ansikt i en video erstattes med et ansikt fra for eksempel en kjent idrettsutøver, politiker eller kjendis, som nå plasseres i en fiktiv sammenheng: Se for deg at en kjent fotballspiller brått opptrer i en video på nettet hvor han står frem som ochlofil, en som blir seksuelt opphisset av menneskemengder.

På YouTube finnes flere eksempler på folk som plutselig har ansiktet til andre kjendiser når de snakker. Moro, men skummelt: For videoer forfalsket ved hjelp av kunstig intelligens er på fremmarsj, og kan misbrukes til cyber-propaganda.

− Deepfake introduserer en farlig og undergravende tvil der man vil måtte spørre seg: Kan dette være falskt? sier Kjersti Løken Stavrum.

Den tidligere generalsekretæren i Norsk Presseforbund og nå administrerende direktør i Stiftelsen Tinius, storeier i VG- og Aftenposten-eier Schibsted, har engasjert seg mye i fenomenet (se egen sak). Hun viser til eksempler der deepfakevideoer spredt via den krypterte appen WhatsApp, som har fått store folkemengder til å gå amok og ta loven i egne hender.

Denne teknologien og det enormt potente propaganda- og desinformasjonsvåpenet utvikler seg uhyre raskt.

Demokratiets manipulator

Deepfakes lages ved at datamaskiner fôres med tilstrekkelig bildemateriale av personen som skal klippes inn i en ny sammenheng.

Denne formen for manipulasjon kalles «face swapping» (ansiktsbytte). Til nå har denne teknologien hatt mange svakheter og vært enkel å avsløre. Men utviklingen går så raskt at snart vil det være omtrent umulig å avsløre dem som har gjort jobben grundig. Det kan også hende at videokvaliteten bevisst er gjort dårlig for å gjøre det vanskelig å finne ut av hva som egentlig er ekte og hva som er juks.

Resultatet kan brukes i propaganda før et valg, for eksempel i form av en video, hvor en politikers ansikt opptrer i en forfalsket video som blir frigitt på sosiale medier.

Dagens amerikanske president Donald Trump kaller ofte nyheter som er negativt og ufordelaktig for ham selv for «fake news». Produsentene av de virkelige forfalskede nyhetene, halvoffisielle russiske trollfabrikker, for eksempel, har etter hvert fått tøffere vilkår, etter hvert som kunnskapen om den har sørget for økende skepsis og kontroll.

Avtrykk

I NRK jobber Henrik Lied som teknologijournalist. Han ser for seg teknologien bak cybervaluta som Bitcoin som våpen mot deepfakes:

Når en video lastes opp til en nettjeneste, vil tjenesten legge videoens unike «fingeravtrykk» i en blokkjede-database. Med ID synlig som vannmerke i videoen, vil ID´en i de fleste tilfeller også være synlig selv om man tar bilde av videoen fra en dataskjerm. Slik vil man kunne oppdage modifiserte kopier av originalvideoen i fremtidige opplastinger.

I tiden fremover spås falske nyheter å bli overgått av deepfake-nyheter, hvor manipulerte videoer blir brukt til spredning av falsk informasjon i stedet for oppdiktede artikler.

Hvordan skal dette kunne bekjempes?

Ordre fra høyeste hold

Stormakten USA tar deepfake-problematikken opp til øverste nivå. Nå har lederen for etterretningskomiteen i Representantenes hus, Adam Schiff, henvendt seg til etterretningsdirektør Dan Coats med bekymring om at teknologien snart kan bli tatt i bruk av «ondsinnede, utenlandske aktører».

«I tiden framover spås

falske nyheter å bli overgått

av deepfake-nyheter

«Ettersom teknologien blir stadig mer avansert og tilgjengelig, kan den utgjøre en trussel mot den offentlige samtalen og nasjonal sikkerhet,» skriver han ifølge CNN.

Sporene etter russernes målrettede påvirkning avi presidentvalgkampen i USA i 2016, der sosiale medier som Twitter og Facebook ble bombardert med desinformasjon, skaper bekymring.

− Under valget i 2016 var min største frykt at Russland skulle spre forfalskede dokumenter blant ekte, eller verre; snike

falske avsnitt inn i ekte e-poster, sa Schiff til CNN.

− Det er fortsatt en stor bekymring før valget i 2020, siden muligheten for å benytte deepfakes vil stå for nok en farlig eskalering av cyber-kriminalitet som ødelegger vårt demokrati, sa han.

Den amerikanske kongressen har bedt om en grundig rapport rundt deepfakes. Etterretningsdirektør Coates er blitt bedt om lede arbeidet. Det sier mye om hvilket nivå bekymringene ligger på.

Kappløp

Ifølge CNN har det amerikanske forsvarsdepartementet og etaten for avansert forskning (DARPA) allerede satt elite-forskere over hele landet til å utvikle metoder og teknikker for å avsløre slike deepfake-videoer.

Tanken er at store mengder med eksempelvideoer, ekte og falske, skal lastes inn i kraftige dataparker med avansert

maskinlæring (kunstig intelligens). Slik skal datamaskinene trene seg opp til å avsløre hvilke videoer som er manipulerte. For det haster:

I et intervju med CNBC i september 2019 sa en av pionerene innen deepfake-teknologi, professor Hao Li, at teknologien trolig bare er seks til tolv måneder unna å gi perfekte resultater. Det betyr at det kan bli nesten umulig å avdekke forfalskninger. Li jobber også for Pinscreen, et selskap som lager programvare som brukes for å skape deepfake-videoer.

Norske redaksjoner utsatt

Norske avisredaksjoner frykter fremtidens manipulasjon gjennom deepfake-videoer like mye som de store mediegigantene. Som for eksempel aviskonsernet Polaris Media, som eier 40 norske mediehus over hele landet med over 80 millioner sidevisninger hver måned fordelt på sine lokale nettaviser.

Øyvind Brunvoll er til daglig digitalredaktør i Polaris-avisen Romsdals Budstikke. Han påpeker at det kan være flere aktører som kan ha en agenda for å få misvisende innhold publisert i en lokalavis i Norge. Brunvoll oppfatter trusselen fra deepfakes så alvorlig at ingen midler bør vurderes som for milde i kampen mot det som truer tilliten til redaksjonelt innhold.

− Redaktørstyrte medier må bekjempe deepfakes med alle verktøy vi har, sier Brunvoll.

− Dessverre har de fleste lokalaviser ikke økonomi til å utføre tung og krevende teknologisk faktasjekking av det som kan være falske videoer, sier han.

− Facebook og andre virkelig store plattformer som distribuerer innhold som kan være deepfake, bør ikke kunne fraskrive seg ansvaret for å kontrollere innholdet de sprer. For oss andre journalister er det egentlig klassisk grundig journalistisk arbeid med kildekritikk som skal til, sier Brunvoll.

For låter noe for godt til å være sant, er det nok ofte fortsatt for godt til å være sant.

Redd folk holder igjen

Bare det at deepfake eksisterer kan skape en usikkerhet som gjør at folk holder seg unna debatter.

For tenk om det som diskuteres bare er tøys ...

− Og da kan det fort bli 1–0 til deepfake uansett, sier Kjersti Løken Stavrum, tidligere generalsekretær i Norsk Presseforbund og nå administrerende direktør i Stiftelsen Tinius, storeier i Schibsted konsernet som blant annet eier Aftenposten og VG.

Løken Stavrum påpeker at mange kilder opp gjennom historien har påberopt seg å være både feilsitert og feilaktig fremstilt.

− Den nylige debatten vi hadde om Tore Sagens innslag i Radioresepsjonen fikk for eksempel fart på seg fordi noen hadde klippet ut lydsporet uten kontekst. Dette er en menneskeskapt parallell til deepfake, forteller hun.

Selv håper hun at utviklingen av kunstig intelligens vil hjelpe et stykke på vei i kampen mot deepfakes. Men når alt kommer til alt, er Løken Stavrum pessimistisk:

− Jeg tror egentlig ikke dette kan utryddes 100 prosent. Norge har en fordel ved at vi er et lite land og et eget språksamfunn med en temmelig oversiktlig debatt. For store samfunn, som for eksempel India, har vi allerede sett

hvordan mobben enkelt kan mobiliseres på farlig vis.

− De redigerte mediene i Norge er nødt til å være så etterrettelige, etterprøvbare og transparente som overhodet mulig. Men her er det like mye et spørsmål om å være konstant på alerten, ha teknologisk kompetanse og dessuten faglig innsikt av typen; «er dette sannsynlig?», mener Løken Stavrum.

− Vi må forstå at dette i bunn og grunn er en kamp mot interessemotsetninger, svindel og sviktende etikk hos avsenderne. Dette er ikke noe et nytt digitalt verktøy kan redde oss fra, avslutter hun.

Per Arne Kalbakk er etikkredaktør i Norsk Rikskringkasting (NRK). Her mates daglig en rekke plattformer med levende bilder som potensielt kan bli forsøkt manipulert med falske videoer.

− Man kan aldri forsikre seg ett hundre prosent mot at man aldri vil bli lurt, sier Kalbakk.

− Men for oss handler dette om å ha gode rutiner for verifisering av nyhetskilder og distribusjon av

bilder og video – både fra nyhetskilder inn til NRK og innholdet vi distribuerer til publikum. Teknologien på dette området er i rivende utvikling.

Denne saken ble første gang publisert 27/11 2019, og sist oppdatert 27/11 2019.